Depuis l’irruption de ChapGPT ou Midjourney il y a quelques mois, l’intelligence artificielle s’est imposée sur la scène médiatique et dans l’agenda politique. Entre promesse de nouvelle révolution industrielle et crainte du « grand remplacement » des emplois, voire de toute les activités humaines, elle suscite tout à la fois espoirs, craintes, fantasmes et appels à la raison ; autant de tensions que l’on retrouve naturellement chez les acteurs publics.

Alors que peut et doit (ou devrait) apporter l’IA à l’action publique ? Comment jauger son bon usage, notamment à l’aune des enjeux d’efficacité et de performance, mais aussi de sobriété et de justice sociale ? Quels sont les risques de son utilisation par les acteurs publics et comment les prévenir ou les réguler ? Comment dépasser la vision technologique au profit d’une vision politique et managériale ?

C’est pour tenter de répondre à ces questions que nous avons organisé, le 5 avril dernier, un webinaire qui a réuni plus de 70 participant.e.s majoritairement issu.e.s des rangs de nos collectivités adhérentes (et, c’est intéressant de le souligner, minoritairement des DSI !), autour du témoignage de Régis Gabriel, Directeur du Pôle Propreté Urbaine à la Ville de Metz et pilote d’une expérimentation pensée pour s’intégrer dans l’approche métier et la logique d’amélioration continue du service, et des interventions passionnantes de deux chercheuses et designers, Pauline Gourlet et Estelle Hary, designers et chercheuses, qui portent toutes les deux une approche critique et pratique des finalités, des modalités et de l’impact du travail avec l’IA.

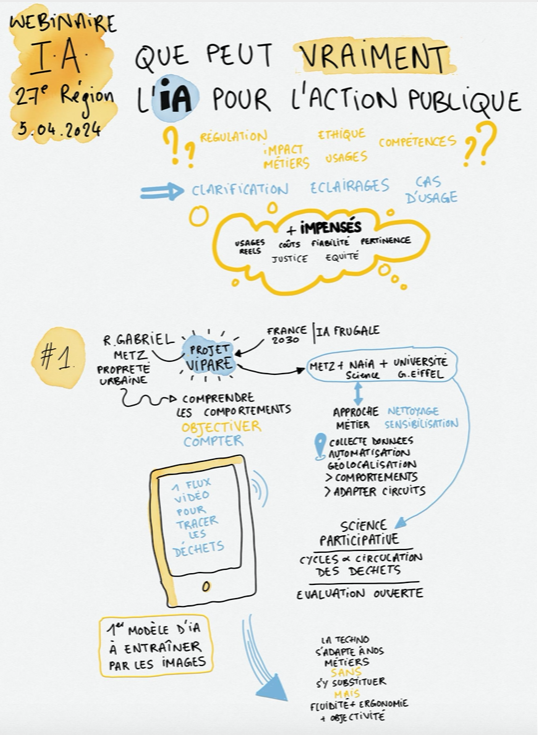

Des questionnements nombreux et divers soulevés par l’IA… et quelques grands impensés

Pour poser le décor, nous commençons par présenter les questions soulevées par l’IA dans les collectivités, telles que nous les avons collectées lors de la préparation du webinaire :

- Quelle sensibilisation et régulation mettre en place en interne ? Quelle doctrine politique et boussole interne ?Quelle stratégie nationale ou mutualisation ?

- Quel impact sur/ou transformation des métiers ? Quelles compétences nécessaires/niveau de maîtrise pour encadrer ces usages ? (En lien avec la formation des agent.e.s)

- Quels enjeux éthiques de la décision (responsabilité, transparence, protection des données, équité (biais) et souveraineté) ? Quel usage durable de ces technologies, dans un contexte de sobriété numérique?

Les besoins exprimés sont alors de trois ordres : clarification (c’est quoi l’IA ?), éclairage sur les enjeux (les risques, les usages), et partage de cas d’étude (expérience en cours, bénéfices réels de l’IA).

Nous évoquons également les impensés qui sont apparus au fil de nos entretiens préparatoires : le manque de maîtrise sur les usages réels de l’IA, dans les pratiques des agent.e.s ; la question des coûts (financier, énergétique, humain) ; la question de la fiabilité, des performances réelles de ces technologies et de leur mesure ; la pertinence de l’IA en terme de résolution d’un problème public.

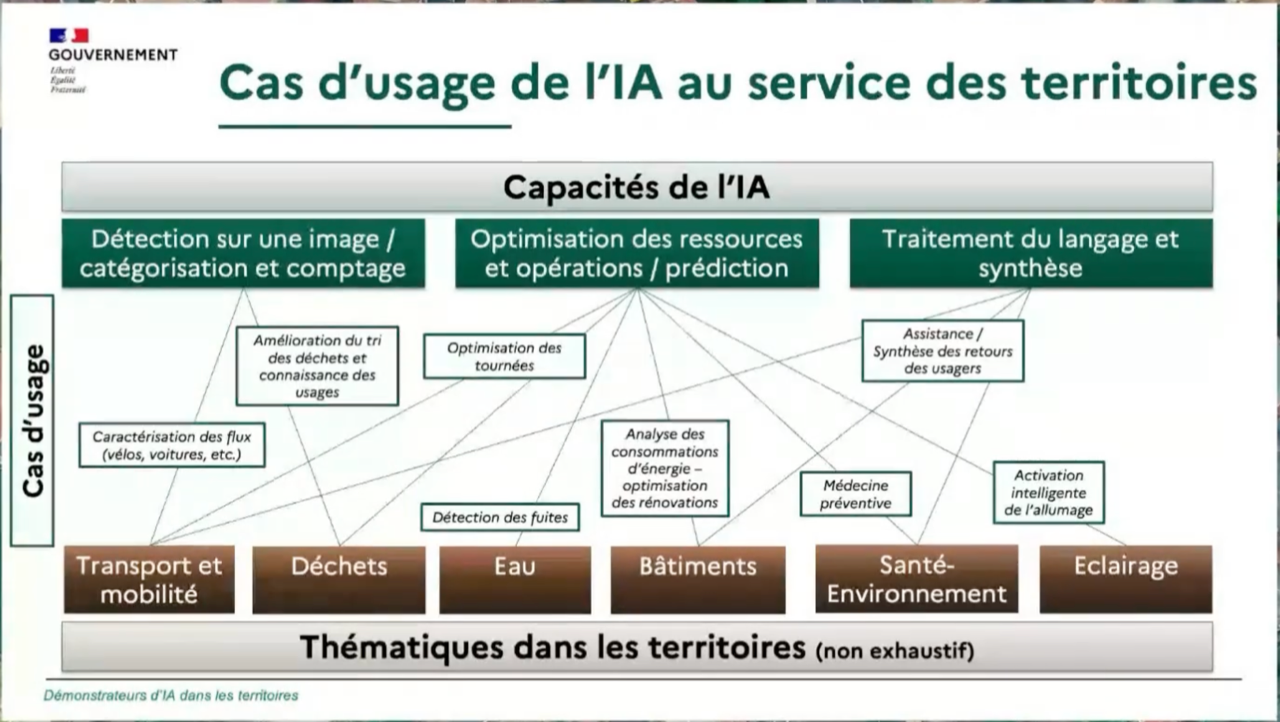

Le projet ViPARE à Metz : mettre l’IA au service de l’évaluation et l’amélioration continue de l’activité du pôle propreté urbaine

Régis Gabriel commence par exposer le contexte dans lequel s’inscrit le projet ViPARE, un dispositif de collecte de données permettant d’analyser la propreté et la salubrité en ville intégrant une intelligence artificielle qui permet de reconnaître des déchets sur un flux vidéo ; à noter que le projet est lauréat d’un appel à projets France 2030 pour soutenir des démonstrateurs d’IA frugal au service des territoires et qu’il est partagé au sein de l’Association des Villes pour la Propreté Urbaine (AVPU) pour permettre à terme à d’autres collectivités de se réapproprier l’outil. Avec l’évolution des usages de l’espace public, la propreté urbaine est confrontée à de nouveaux défis et doit de plus en plus prendre en compte les dimensions de saisonnalité, de sociologie des quartiers ou de comportements des usagers. La question de l’objectivation et de l’évaluation des critères de propreté se pose de manière accrue et passe principalement par le comptage des déchets.

La jeune société NAIA Science a ainsi proposé à la Ville de Metz un outil de reconnaissance des déchets en milieu naturel développée avec l’ONG Surfrider. Un dialogue s’est mis en place pour approfondir et adapter cette technologie à une approche métier (qui va faire les relevés photographiques ? comment ? que peut-on attendre ou pas des agent.e.s de propreté ? – par exemple, pas de se promener dans la rue avec une perche au-dessus de la tête pour les prises de vue !) et à une logique de frugalité (une solution capable de tourner sur le téléphone portable d’un.e agent.e), tout en pensant son articulation avec l’organisation et les outils existants (indicateurs objectifs de propreté/ grilles d’évaluation opérationnelle). Ce processus a permis de clarifier les besoins auxquels la solution devait répondre : automatiser et simplifier la collecte des données par les agent.e.s (aujourd’hui, un agent est mandaté, sur 25% de son temps, pour compter les déchets dans un échantillon réduit de rues), caractériser plus finement et géolocaliser plus précisément les déchets, et élargir le périmètre (voirie, trottoirs, espaces verts). L’IA doit ainsi permettre de réduire le temps de recueil et traitement des données et augmenter les surfaces couvertes et la représentativité des données, pour aboutir à une cartographie plus fine des points noirs. L’objectif final étant d’adapter et d’améliorer les circuits de collecte des déchets (« nettoyer là où c’est effectivement sale, pas là où il y a le plus de doléances »), mais aussi de mieux cibler les actions de sensibilisation ou de verbalisation pour changer les comportements à l’origine des déchets. Le projet intègre également une dimension de sciences participatives, le labo Eau Environnement de l’Université Gustave Eiffel de Nantes ayant rejoint le consortium pour travailler sur des modèles de diffusion des déchets en milieu urbain, notamment via les réseaux d’eau (« du caniveau au cours d’eau »), et améliorer le fonctionnement des réseaux d’assainissement, en impliquant des étudiant.e.s et des citoyen.ne.s.

Pour Régis, il faut sortir des fantasmes autour de l’IA : « VIPARE reste un outil qui utilise l’IA au service de l’amélioration et l’évaluation d’une activité. Il faudra toujours un agent pour tenir le téléphone, pour prendre les vues et corriger les défauts de reconnaissance. La technologie ne se substituera pas à nos métiers de nettoiement, mais leur apportera plus d’ergonomie, d’objectivité et d’efficacité, dans une logique d’amélioration continue ». Il explique d’ailleurs la facilité d’appropriation de l’outil par les agents par sa simplicité d’utilisation, sa stabilité (des pré-requis qu’il a posés) et le fait qu’il simplifie leur travail et leur fait gagner du temps.

La présentation de Régis est accessible ici.

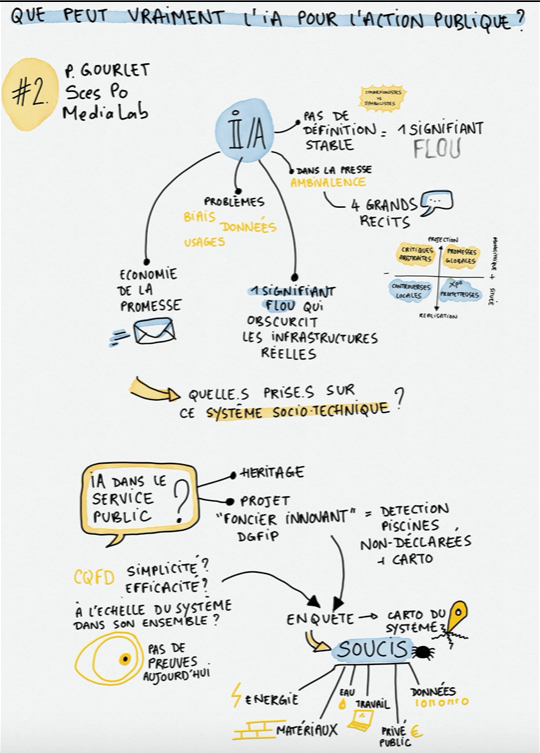

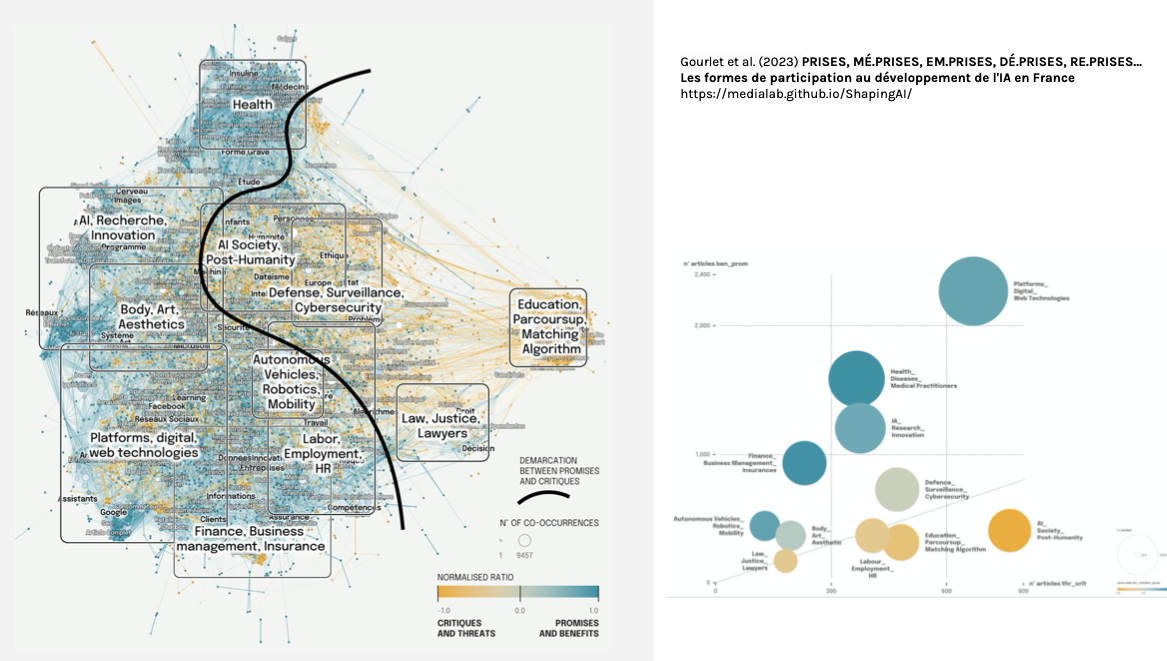

Visibiliser les nombreuses entités éclipsées par les modèles : comprendre et agir à partir des « soucis » des praticien.nes de l’IA

Pauline Gourlet, designer et chercheure associée au médialab de Sciences Po, commence par poser la question de l’usage non-controversé du terme d’intelligence artificielle. Rappelant qu’il n’y a pas de consensus scientifique aujourd’hui (ni depuis ses premiers développements dans les années 50) sur la définition de l’IA (notamment sur la distinction algorithme / intelligence artificielle), Pauline raconte comment, au sein du projet de recherche international Shaping AI, elle s’est justement intéressé à la manière dont la notion apparaissait dans la presse ces 10 dernières années. À travers une grande variété de secteurs d’activité et 4 types de récit (critiques abstraites, promesses globales, expérimentations prometteuses, controverses locales), ces récits ont largement participé à la fois à former les imaginaires (catastrophistes ou techno-béats) mais aussi à légitimer le développement et l’intégration de nouveaux dispositifs computationnels. Plus tardivement, on a vu apparaître de nouveaux cadrages avec l’émergence de nouveaux problèmes, comme par exemple les biais raciaux de la reconnaissance faciale, le fait qu’on ait entraîné des modèles d’IA sur des données sans le consentement de leur propriétaire ou encore les usages de ces technologies à des fins d’ingérence politique.

Pour Pauline, l’utilisation de cette notion floue d’IA sert avant tout une économie de la promesse (le fameux fake it till you make it de la Silicon Valley), animée par la quête de nouveaux investissements et l’enrôlement d’un nombre toujours croissant d’acteurs, sans toujours faire la preuve de ce qu’elle avance. Par ailleurs, le modèle/logiciel, présenté comme central dans l’IA, est en réalité pris dans un écosystème socio-technique très large, une chaîne intégrant des entités invisibilisées (des déchets électroniques à l’eau ou aux travailleurs du clic sous-payés), non perçues comme parties prenantes du système alors qu’elles lui sont indispensables. C’est pour mieux décrypter le système, trouver des prises pour influencer les développements futurs et dépasser la confiscation du débat par les seuls expert.e.s techniques, que Shaping AI a produit une carte des soucis des praticien.ne.s de l’IA en France.

Bien loin de l’idée très répandue qu’il est nécessairement vecteur de simplicité et d’efficacité ou d’économie, l’IA dans le service public hérite de tous ces enjeux et problèmes, comme Pauline le montre à travers le cas d’étude « Foncier innovant ». Initié en 2017 par la Direction générale des finances publiques (DGFiP), ce système permet de détecter les piscines non-déclarées par leur reconnaissance sur des images aériennes, l’objectif étant d’aller jusqu’au report automatisé de tous les objets bâtis sur les plans cadastraux. En donnant à voir toutes les entités de la chaîne (bases de données, serveurs, textes réglementaires, acteurs, interfaces numériques, financement, travailleur.euse.s…), cette enquête participative a révélé la pluralité des « soucis » des praticien.nes en prise avec les entités de ce « nouvel agencement socio-techniques » et mis en lumière les perspectives politiques qui sous-tendent son déploiement.

L’enquête montre que la preuve n’est pas faite quant aux promesses initiales : le nouveau dispositif n’est pas plus simple, loin s’en faut et n’est, à ce jour, pas même efficace. Une dimension, déjà bien documentée dans d’autres situations et qu’on retrouve ici, concerne le travail qui ne disparaît pas : il mute (parfois à l’étranger dans des usines du clic) et se déplace, entraînant au passage la dévalorisation, la précarisation et la démotivation des travailleur.euse.s. Loin de se limiter aux modèles, on comprend à la lumière de ce cas que « l’IA » devrait s’appréhender et être évaluée à partir de la reconfiguration des rapports sociaux que ces nouveaux agencements instaurent.

Les mutations du travail des agent.e.s sont donc bien sûr un aspect déterminant dans cette enquête, mais Pauline conclut en mettant également l’accent sur quelques autres enjeux cruciaux à ses yeux, et insuffisamment pris en compte dans l’évaluation des systèmes computationnels mis en œuvre :

- Les ressources (matériaux, énergie, eau) nécessaires pour produire ces systèmes et les faire fonctionner, et les émissions considérables de CO2

- L’injonction à la valorisation des données de l’administration (pour elles-mêmes, en dehors des finalités initiales et du contexte de leur production), qui sont avant tout utilisées pour favoriser des innovations commerciales.

- La perte de savoir-faire et/ou de travailleur.euse.s motivé.e.s sur des savoirs critiques pour le bon fonctionnement des services publics.

- La participation (des agent.e.s et plus largement des citoyen.ne.s) au développement des instruments de l’action publique

- Les conséquences sur la relation entre citoyen.ne.s et administrations publiques (au-delà des enjeux d’exclusion et de précarisation liées à la dématérialisation, la question de la justice face à l’administration se pose).

La présentation de Pauline est accessible ici.

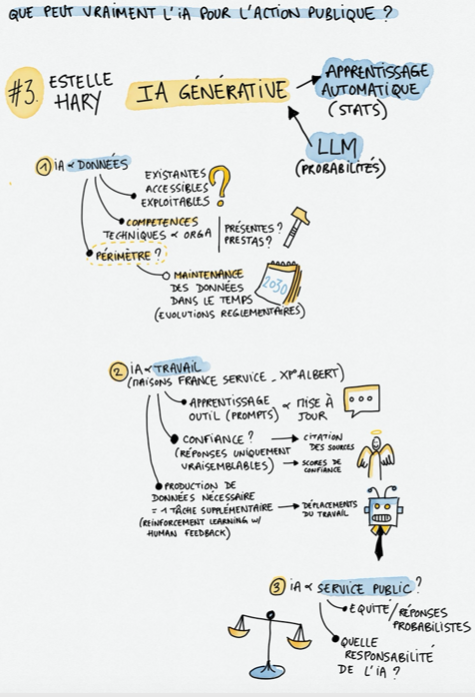

IA générative & service public : limites et premiers retours d’expérience

Estelle Hary, designer et co-fondatrice du studio Design Friction, doctorante au sein du RMIT University et affiliée au Centre de recherche en design, aborde plus spécifiquement l’IA générative, qui entre dans le champ de l’apprentissage automatique qu’elle définit comme « des algorithmes qui font ressortir des sortes de vérité statistique et les réappliquent à d’autres données ». Le secteur public s’intéresse aujourd’hui particulièrement aux LLM (Large Langage Model, en Français : grands modèles de modèles de langage) dont Estelle rappelle qu’ils produisent des résultats relevant du probable et non pas d’une vérité absolue (sur le modèle probabiliste et ses incidences, écoutez cet épisode du Code a changé !)

La mise en place d’IA générative dans l’action publique pose d’abord la question de l’accès et de l’exploitation des données (sans données, pas d’IA !), avec 4 situations possibles :

- Les données sont accessibles et exploitables (par exemple, pour entraîner le LLM Albert, la DINUM utilise les fiches de service-publics.fr qui sont en open data et dans un format facilement exploitable par des machines).

- Les données sont accessibles mais pas directement exploitables (telles que les informations disponibles sur les sites administratifs). Il faut alors faire un travail préalable de récupération et de qualification des informations afin de pouvoir les utiliser.

- Les données ne sont pas accessibles mais sont exploitables, par exemples celles détenues par d’autres administrations. Cela pose la question du partage de ces données entre administration, partage qui est censé être facilité avec la Loi 3DS adoptée en 2022 dont l’esprit est dans la lignée du dispositif « Dites-le nous une fois ».

- Les données n’existent pas, il faut les créer ou abandonner le projet d’IA.

Dans 3 cas sur 4, il faut donc mettre en place des nouveaux processus techniques et organisationnels et faire appel à des compétences spécifiques, par exemple des data scientists pour travailler les données et les modèles d’IA ou des juristes spécialisés dans le numérique pour s’assurer de la conformité du traitement de données. Des compétences dont ne disposent pas toujours les administrations.

Autre problématique importante liée aux données, celle de leur périmètre et leur maintenance, ayant un impact direct sur la pertinence des résultats produits par une IA générative. Albert, par exemple, qui est en expérimentation dans des Maisons France Services, n’a pas, à l’heure du webinaire, d’informations sur des dispositifs spécifiques à chaque territoire (régions, départements, etc.), car aucune données relatives à ceux-ci ne sont incluses dans le jeu d’entraînement du modèle, même si ces informations pourraient être utiles aux conseiller.e.s France Service. Se pose également la question de la maintenance et la mise à jour de ces données dans le temps, véritable défi technique et organisationnel tant la matière administrative et législative évolue vite. Faudra-t-il faire désapprendre aux LLM une connaissance au profit d’une autre à chaque fois qu’un dispositif évolue ? Et comment le faire en pratique ?

Estelle aborde également les effets de l’IA générative sur le travail, à travers l’exemple des conseiller.e.s des Maisons France Services, qui accompagnent les usagers dans l’accomplissement de diverses démarches administratives et sont ainsi amené.e.s à consulter, confronter et synthétiser différentes sources d’information. Avec Albert, le ou la conseiller.e pose directement une question à l’outil, puis transmet à l’usager.e la réponse générée. Ce changement de pratique induit plusieurs problématiques :

- l’apprentissage de l’outil LLM, qui ne fonctionne pas comme un moteur de recherche et suppose de formuler la bonne question (l’invite ou le prompt)*, cette formulation ayant un impact sur la qualité et la pertinence de la réponse (cet apprentissage devant être réitéré à chaque mise à jour du modèle) ;

- les enjeux de confiance et d’esprit critique à conserver face aux réponses générées par les LLM qui ne sont pas toujours fiables. Tout en étant vraisemblables, ces réponses peuvent comprendre des oublis ou des hallucinations (invention de faits ou d’informations)… Ainsi, dans le cadre de l’expérimentation, les conseiller.e.s France service sont invité.e.s à utiliser l’outil sur des tâches ou questions qu’ils ou elles maîtrisent pour pouvoir vérifier la véracité des réponses, mais que se passerait-il dans le cas contraire ? Un mécanisme de citation des « sources » (fiches service-public.fr) est notamment testé pour que la ou le conseiller.e puisse vérifier rapidement l’information. Parmi les autres pistes envisagées figure la mise en place d’un score de confiance sur la réponse ou la possibilité pour Albert de dire « je ne sais pas ».

- les nécessaires « feedbacks » (retours) sur la qualité des réponses fournies par Albert pour l’améliorer. En effet, l’amélioration des modèles de LLM repose en grande partie sur les retours faits par leurs utilisateurs (mécanisme d’apprentissage par renforcement à partir de rétroaction humaine – RLHF) ce qui équivaut à produire des données d’évaluation des réponses générées, via un retour de l’agent.e sur la qualité perçue de la réponse (en l’occurrence un clic + ou -). Cela constitue un nouvel exemple de déplacement du travail lié à l’IA. Parfois cette production de données nécessite même la création d’un service dédié, à l’image de celui mis en place par la Cour de Cassation pour vérifier la pseudonymisation de décisions de justice par un algorithme. Estelle invite ainsi les administrations qui souhaitent développer une IA à se demander quels impacts cela va voir sur les métiers existants, et quelles nouvelles tâches et nouveaux métiers cela va requérir … À titre d’exemple, l’IGN, qui s’est engagé dans un gros effort de reconnaissance d’images aériennes, pointe le risque de ne pas avoir formé suffisamment de personnes (et anticipé ce besoin de formation) pour reconnaître les arbres en télédétection et annoter les bonnes informations sur les images.

Elle conclut par une réflexion plus large, notamment sur les enjeux éthiques de l’utilisation de l’IA par les services publics : la logique probabiliste d’un LLM pouvant fournir des réponses différentes à des personnes différentes pour une même question pourrait porter atteinte au principe d’égalité devant le service public ou quid de la responsabilité des administrations de ce qui est généré par un LLM : car qui est responsable dans le cas d’un chatbot qui participerait à une décision administrative ou expliquerait à un usager comment contourner la loi ou ne pas payer des impôts (comme l’a fait récemment un chatbot de la Ville de New York) ? Sur ce dernier point, ne vit-on pas avec l’IA une inversion de la charge de la preuve, où il revient à l’administré.e de faire la preuve que l’administration se trompe, alors qu’avant, c’était à l’administration de justifier sa demande ?

*On vous recommande d’ailleurs cet article intéressant sur les manières de pirater les IA via ces fameux prompts.

Et après ?

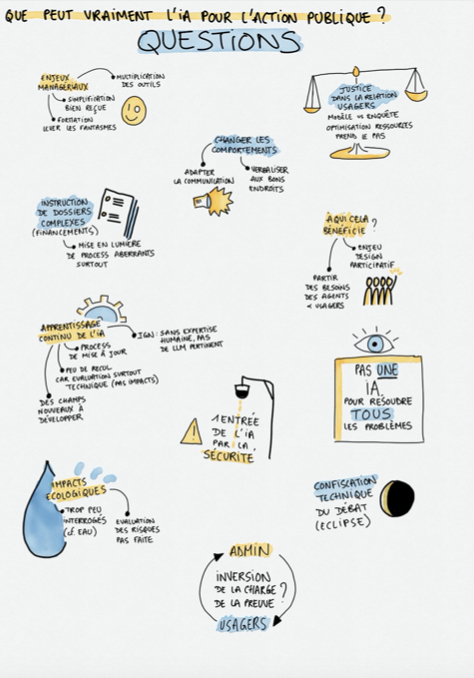

Les présentations suscitent de nombreuses réactions, à commencer par un appel à réaliser une carte des controverses autour de l’IA et/ou des domaines qu’il recouvre, pour que chacun.e puisse se sentir autorisé.e à s’emparer du sujet et sortir de visions manichéennes ou idéologiques. Plusieurs participant.e.s s’interrogent aussi : pour qui l’IA est-elle porteuse d’avancées ? à qui profite-t-elle ? Quelles injustices génère-t-elle ? Autant de critères jamais pris en compte pour évaluer ces systèmes aujourd’hui.

Pauline invite à revenir à l’esprit initial du design participatif, celle d’une participation authentique, qui repart des besoins identifiés dans l’activité de travail des agent.e.s, comme à Metz. A l’inverse, le développement de Foncier innovant s’est fait sans impliquer les agent.e.s concerné.e.s, et malgré la promesse de ne pas remplacer des ETP il y a eu un déplacement du travail, d’une part vers de l’annotation (qui se fait souvent à l’étranger), d’autre part vers les usagers qui prennent en charge une partie du travail auparavant fourni par l’administration.

Au-delà de ses promesses, l’IA semble donc bien aujourd’hui soulever des questions politiques et des problèmes connus de conduite de changement, mais qui semblent peu audibles dans un climat de confiscation de la parole publique par des experts de la technologie. De même la durabilité de ces systèmes (notamment au regard de la ressource en eau), dont on sait en principe évaluer les risques, n’est pas interrogée. Pour Estelle, « on monte des projets pour lesquels on n’aura pas les moyens de calcul nécessaires faute de ressources » … Sur le coût environnemental de l’IA, on vous recommande cet article édifiant ou encore ce livre qui met l’accent sur les questions minières.

Pour finir, on vous partage quelques idées dignes de Kafka glanées dans le chat du webinaire : faut-il inventer un métier de coach sportif pour IA ? Faudrait-il des IA pour produire des dossiers de demande de financement complexes (tellement complexes qu’il existe parfois déjà des IA pour les instruire !) ? L’usager devra-t-il faire des copies d’écran tout au long de ses démarches pour montrer sa bonne foi en cas d’erreur, dans un système où la statistique probabiliste est vue comme toute puissante ?

Ami.e.s de collectivités, les questions soulevées dans ce webinaire vous intéressent ? Vous rêvez d’ouvrir un chantier expérimental sur le sujet, faites-nous signe à crotrou@la27eregion.fr !

*****************************************************************

En bonus, voici la captation visuelle du webinaire faite par notre complice Martin Préaud, chef de projet innovation territoriale au Département de la Seine-Saint-Denis (merci Martin !)