Il y a un an, nous décrivions dans un billet pourquoi la 27e Région s’est ré-intéressée à l’évaluation, et comment nous tentons dorénavant d’intégrer une posture évaluative (cf Quadrant Conseil) dans nos programmes et notre activité en général. Depuis, nous regardons également ce qui se passe dans nos réseaux, et à ce titre nous avons été frappés de voir certaines collectivités mettre en place des pratiques très originales -quelquefois sans les promouvoir comme des démarches d’évaluation, mais plutôt comme des outils de pilotage, de stratégie, de collaboration ou de montée en compétences. C’est pour en parler qu’en janvier dernier nous avons réuni plusieurs d’entre elles (*). Nous reprenons ici ce qui s’est dit durant cet échange, tout en essayant de le mettre un peu ordre !

(*) Les métropoles de Grenoble, de Nantes, de Lille, les villes de Nancy et de Malaunay, la Région Occitanie, la DITP, avec l’expertise de Quadrant Conseil et de l’Université de Paris-Créteil.

Une question de vocabulaire

L’évaluation est souvent connotée négativement, mais plusieurs évolutions sémantiques pourraient nous aider à élargir nos représentations de l’évaluation. Tout d’abord, plutôt que d’évaluation, certains auteurs parlent maintenant de « systèmes d’évaluation » pour mieux sortir d’une vision « one shot » de l’évaluation, et caractériser son caractère continu et systémique. Certains emploient également l’appellation « Suivi, Evaluation, Redevabilité, Apprentissage » (SERA), une façon de mettre l’accent sur des fonctions certes présentes mais souvent occultées dans les démarches d’évaluation :

- Le suivi est le processus continu de collecte systématique d’informations, selon des indicateurs choisis, pour fournir aux gestionnaires et aux parties prenantes d’une action de développement en cours, des éléments sur les progrès réalisés, les objectifs atteints et l’utilisation des fonds alloués ;

- L’évaluation d’une politique publique, à proprement parler « c’est former un jugement sur sa valeur » pour citer le rapport Viveret (1989)

- La redevabilité est l’obligation de rendre compte de façon claire et impartiale sur les résultats et la performance, au regard du mandat et/ou des objectifs fixés ;

- L’apprentissage, enfin, est un processus d’acquisition de savoirs, de connaissances, de savoir-faire, mais aussi un processus perpétuel, une démarche continue de perfectionnement qui passe par la capacité à identifier les erreurs.

Ainsi dépliée, l’évaluation apparait à nouveau comme une pratique complète et aidante, pouvant aider les organisations à clarifier leurs intentions, à collecter des données pour évaluer leur efficacité, à contrôler et adapter leurs leviers de changement, à apprécier leur capacité à répondre et s’adapter en temps réel.

Penser l’évaluation en partant de ses usages

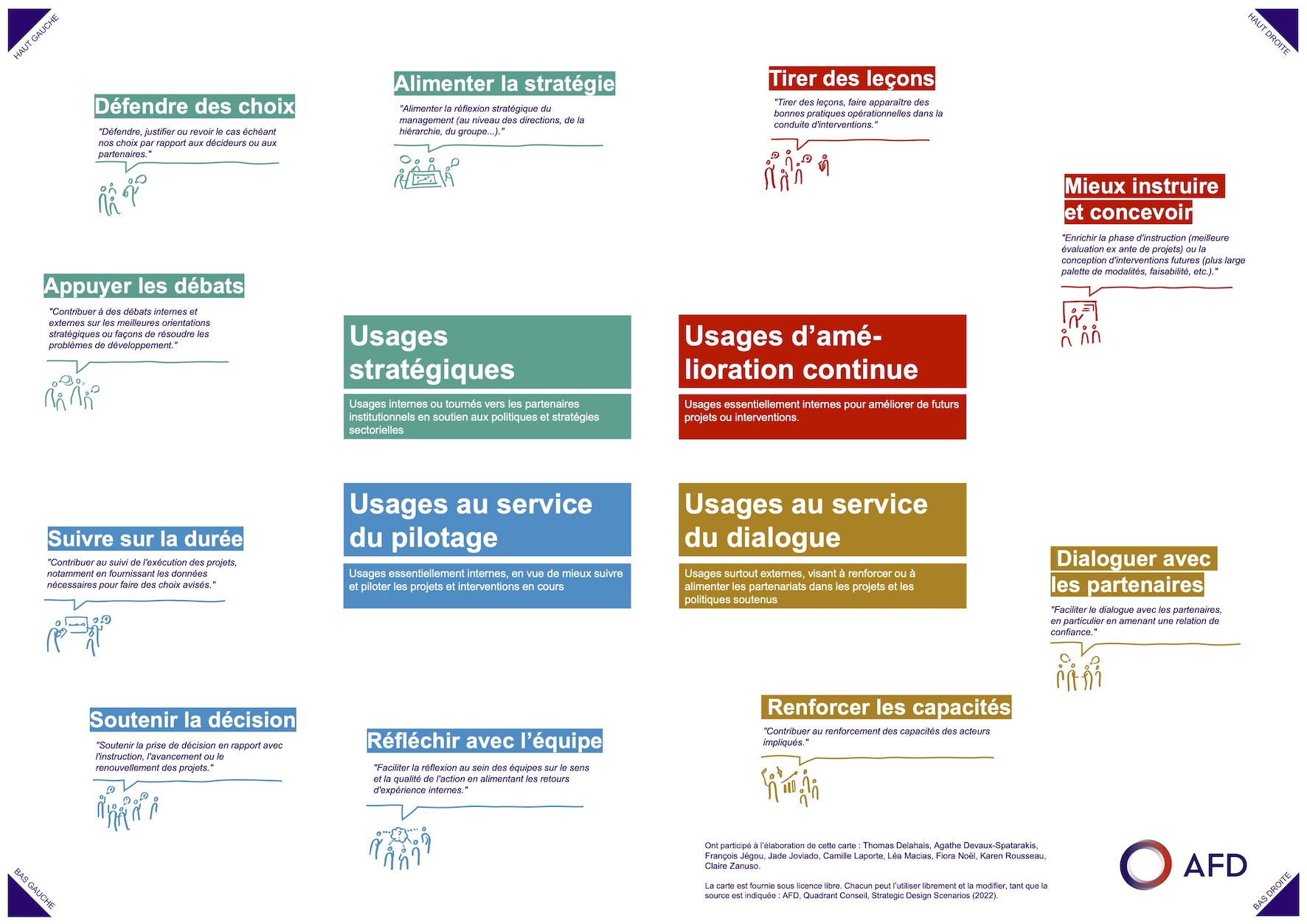

A la 27e Région, nous sommes revenus à l’évaluation non par la contrainte, mais en écoutant nos besoins du moment : en particulier sortir du flou autour de l’innovation et du risque d’innovation-washing, mais aussi questionner les difficultés que nous éprouvions à concevoir nos programmes. L’évaluation ne se pense bien qu’à partir des usages qu’on en attend ! Mais comment y voir plus clair dans les usages possibles ? En 2022, pour sortir d’un débat technique sur l’évaluation, l’Agence française de développement, Quadrant Conseil et Stratégie Design Scénario ont publié une cartographie des usages de l’évaluation. La carte est organisée autour de 4 familles d’usages : stratégiques, au service du pilotage, de l’amélioration continue, et enfin au service du dialogue. Pour chaque familles d’usages, des propositions méthodologiques sont faites.

Cas d’usage : l’évaluation au service du pilotage à Nantes Métropole

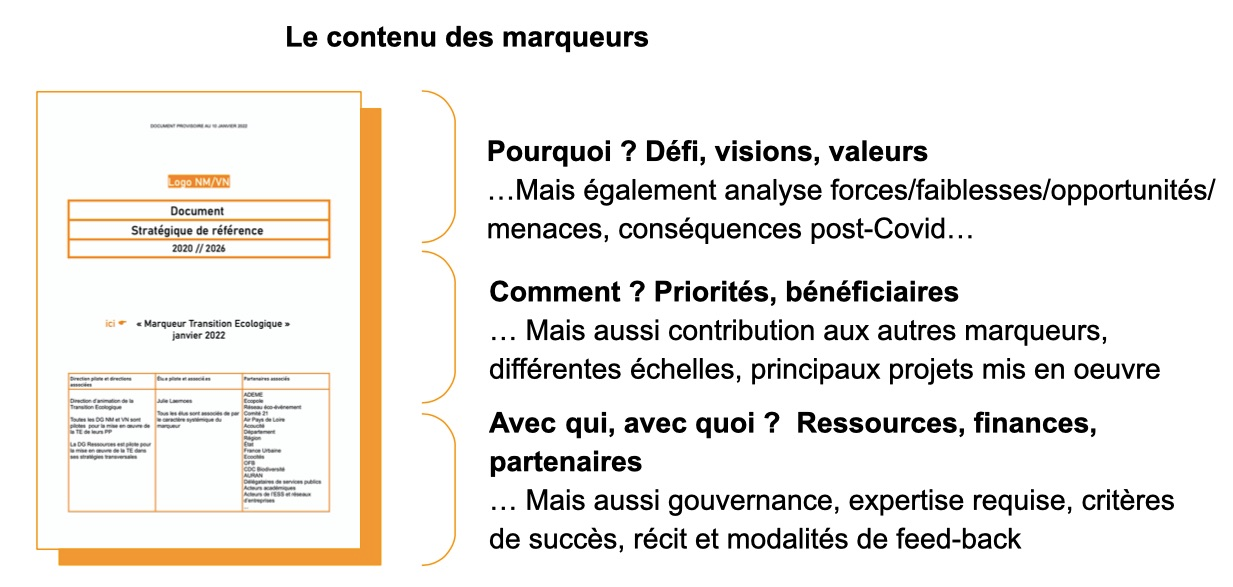

Un premier exemple permet d’envisager l’évaluation sous l’angle du pilotage. Comment donner un cadre commun au projet de territoire (porté politiquement) et au projet de collectivité (son pendant interne) ? Clarifier les priorités, et fédérer autour d’une vision de l’action publique ? En 2021, La Métropole de Nantes s’est dotée de six marqueurs, sortes de référentiels de quelques pages décrivant précisément les théories portées par la Métropole sur six priorités transversales, déclinées dans les 26 politiques publiques de la collectivité : la transition écologique, l’égalité, le dialogue citoyen, la proximité, l’innovation-expérimentation et l’alliance des territoires. Chacune d’entre elle n’en reste pas à la profession de foi, mais est déclinée pour être la plus opérationnelle possible. Maintenant que les points cardinaux sont posés, la prochaine étape sera d’évaluer les dispositifs existants au regard de ces marqueurs, histoire de garder le cap !

D’autres exemples permettent d’envisager l’évaluation comme outils de pilotage :

- Les marqueurs de Nantes sont inspirés de la théorie de changement, « une vision explicitement documentée (et donc évaluable) de la façon dont on pense que le changement doit se produire » (Rick Davies). Pour réfléchir à sa théorie de changement, la chercheuse Lindsay Cole propose de compléter cette fleur, individuellement puis en équipe.

- La métropole de Grenoble a établi un « arbre des objectifs », né en 2015 d’une volonté de « dé-siloter » son fonctionnement, aujourd’hui intégré dans le dialogue de gestion ; Il sert tout autant à rendre explicite la déclinaison de grands enjeux en réalisations concrètes, de clarifier ce qui fait politique publique, qu’à piloter l’action publique en servant de repère et de support de dialogue dans chaque service. Cette vidéo décrit son fonctionnement.

Autre cas d’usage : l’évaluation au service de l’amélioration continue à Nancy

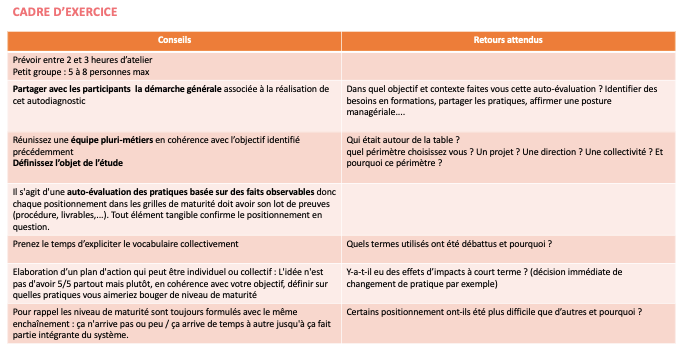

En partenariat avec une équipe de recherche de l’ERPI, la Ville de Nancy a imaginé un atelier d’auto-évaluation des pratiques professionnelles des agent.e.s pour en déduire la capacité d’innovation d’une organisation, d’une équipe, ou d’un projet. Grâce à une grille de questions qui en appellent à des pratiques quotidiennes, le niveau de maturité est défini par des preuves tangibles, autour desquelles se construit dans un second temps un plan d’action pour évoluer et gravir quelques paliers de maturité. L’objectif de ce plan d’action est d’identifier des leviers actionnables à court terme, qui représentent peu d’efforts, et des besoins qui nécessiteront l’option « pente douce », pour une montée en maturité dans le temps long.

D’autres exemples illustrent l’usage de l’évaluation pour des objectifs d’amélioration continue :

- Une matrice de montée en maturité des laboratoires d’innovation, testée par une dizaine d’équipes dans le cadre des Labonautes

- Une grille d’auto-évaluation « Quel développeur systémique êtes-vous ? » (page 34), pour aider les développeurs économiques à mesurer leur niveau de pratique en matière d’approche systémique, testé par plusieurs dizaines d’agents de la métropole de Montpellier dans le cadre du programme Rebonds

- Une grille d’auto-évoluation « Quel style d’innovateur êtes-vous ? », pour établir des typologies d’innovateurs dans une collectivité, testé par une cinquantaine d’agents nantais dans le cadre de Sonar

Ces exemples sont un premier aperçu de la diversité des usages possibles de l’évaluation. Et vous, quels usages en faites-vous ou aimeriez-vous en faire ?